2026-01-22_JAX_挑戰-CUDA-的高效能運算新星

JAX:挑戰 CUDA 的高效能運算新星

☘️ Article

- 看完也只能理解部分,但產業友人說 G 社正在大力推 jax 開源,就還是把資料找來了解一下

- 如此一來可以讓 pytorch 在框架不改的前提下導入,目標當然是 cuda 的城牆

- jax 是由 Google DeepMind 開發的開源工具庫,專門用來做高效能的數值運算。外觀像 Python 界最通用的數學庫 NumPy,核心能力是讓原本只能在 CPU 上慢慢跑的 Python 程式,能夠直接在 GPU 或 TPU 加速器上快速執行

--- 以下 notebooklm 伴讀書童 --- - "JAX 強大在於它能對你寫的函式進行「轉換」,讓程式碼自動獲得新能力

- 自動微分 (grad) —— 解決微積分難題

- 概念:在訓練 AI 模型時,我們需要計算「梯度」(Gradient) 來修正錯誤率。這本質上就是微積分的應用。

- JAX 的做法:你隨便寫一個 Python 函式,只要用 grad() 包起來,JAX 就會利用「自動微分 (Autodiff)」技術,直接產生一個能計算該函式導數 (微分) 的新函式。

- 高中生視角:想像你寫了一條數學公式,電腦自動幫你導出它的微分公式,不用你自己手算,這對訓練神經網路至關重要。

- 向量化運算 (vmap) —— 一次處理全部,拒絕慢速迴圈

- 概念:寫程式時,如果要對 100 筆資料做一樣的運算,初學者通常會寫一個 for 迴圈跑 100 次。但在高效能運算中,迴圈非常慢。

- JAX 的做法:vmap() 可以把你「處理單筆資料」的函式,瞬間轉換成「可以一次平行處理整批 (Batch) 資料」的函式。

- 高中生視角:本來你是老師,改考卷要一張一張改 (寫迴圈);用了 vmap,你就像影分身一樣,可以同時改全班的考卷,而且不用重寫改考卷的規則。

- 即時編譯 (jit) —— 效能催化劑

- 概念:Python 是直譯語言,一行一行執行,速度較慢。

- JAX 的做法:jit (Just-In-Time compilation) 會觀察你的運算過程,把它編譯成機器碼。它會移除不必要的步驟、把多個小運算合併成一個大運算 (Operation Fusion),讓硬體執行效率最大化。

- 高中生視角:就像你原本看著食譜做菜,看一步做一步 (慢);jit 像是大廚把食譜背下來,並重新安排流程 (例如切菜時順便燒水),動作變得超級流暢快速。

- 擴展性:從一台筆電到超級電腦

- JAX 的另一個重點是「擴展性 (Scaling)」與「平行運算 (Parallelization)」。

- 統一的介面:不管你是用電腦 CPU,還是幾千顆 TPU,JAX 的程式碼幾乎不用改。它背後依賴 Google 的 XLA (Accelerated Linear Algebra) 編譯器來處理硬體溝通。

- 自動平行化:透過 jit,你只需要告訴電腦資料怎麼切分,JAX 就會自動把運算工作分配給多個晶片去跑,你不需要自己寫繁瑣的通訊程式碼。

- 進階控制:給高手的「手排模式」

- 雖然 JAX 自動化很強,但也保留了讓專家「手動介入」的空間,這在追求極致效能時很有用。

- shard_map —— 精準控制多晶片

- 如果你不滿意編譯器自動分配工作的方式,可以用 shard_map。它讓你以「單一裝置」的視角,手動控制晶片之間如何交換資料 (例如在訓練超大型語言模型 Transformer 時)。

- 核心語言 (Pallas) —— 控制硬體細節

- 這是更底層的控制。Pallas 是一種能讓你用 Python 語法,但直接控制 GPU/TPU 記憶體如何讀取與寫入的語言 (Kernel Language)。

- 它允許你管理「記憶體管線 (Memory Pipeline)」,確保運算單元永遠有事做,不會空轉等待資料。這雖然難寫,但能達到硬體的物理極限效能。

- 總結

- JAX 就像是一套現代化的科學運算工具箱:

- 入門簡單:長得像 NumPy。

- 功能強大:自動幫你算微積分 (grad)、自動幫你平行處理 (vmap)、自動幫你加速 (jit)。

- 深不見底:如果你是專家,它還允許你深入底層控制硬體細節 (Pallas/shard_map)。

- JAX 就像是一套現代化的科學運算工具箱:

- 這使得 JAX 成為目前科學研究和 AI 開發的前沿工具。"

- https://www.youtube.com/watch?v=juy9nrcTBck

✍️ Abstract

JAX:挑戰 CUDA 的高效能運算新星

- JAX 是 Google DeepMind 開發的開源數值運算庫,旨在解決 Python 在高效能運算上的先天劣勢。

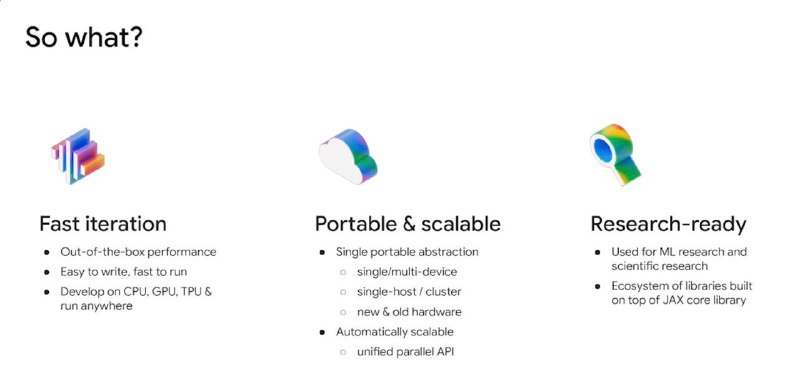

- 快速迭代與高效能:它保留了 NumPy 簡單易用的語法特性,具備開箱即用的效能表現,語法易於撰寫且執行速度快,開發者可以在 CPU、GPU、TPU 等不同硬體環境間無縫開發與運行。

- 這不僅是工具更新,更是 Google 對抗 NVIDIA CUDA 生態系護城河的戰略佈局。

- 強大的便攜性與擴展性:提供單一且便攜的抽象化層級,無論是單一裝置、多裝置、單機或是大型集群,乃至於新舊硬體皆能適用;並透過統一的平行化 API 達成自動化擴展。

- 專為研究需求設計:已被廣泛應用於機器學習與科學研究領域,並在核心函式庫之上建立了完善的生態系統與工具鏈。

核心技術優勢

- grad (自動微分):能自動計算函式的導數,解決 AI 模型訓練中複雜的微積分問題,開發者只需撰寫一般函式即可自動獲得求導能力。

- vmap (向量化運算):可將處理單個樣本的函式自動轉換為可同時平行處理整批資料的函式,有效取代緩慢的傳統迴圈運算。

- jit (即時編譯):透過即時編譯技術將程式碼轉化為機器碼,並執行運算融合優化,減少不必要的步驟以極大化硬體執行效率。

- 高度擴展性:利用 XLA 編譯器,JAX 的程式碼可在不同硬體間無縫切換,並自動將運算任務分配至多個晶片,簡化了平行運算的難度。

- 進階手動控制:提供 shard_map 功能讓專家精準管理多晶片間的資料交換,並透過 Pallas 核心語言直接操作硬體底層的記憶體讀寫。

專有名詞

- JAX:Google 開發的開源數值計算函式庫,結合了 Autograd 自動微分與 XLA 即時編譯技術,專門用於高效能的機器學習研究。

- CUDA:由 NVIDIA 推出的並行運算平台與編程模型,讓開發者能利用 NVIDIA GPU 進行通用計算。

- XLA:全稱為 Accelerated Linear Algebra,是 Google 開發的線性代數編譯器,專門用來優化並加速 JAX 與 TensorFlow 的運算。

- 自動微分:一種計算函式導數的技術,透過分解運算步驟並套用連鎖律,自動計算梯度以優化機器學習模型。

- 運算融合:編譯優化技術,將多個運算步驟合併為一個大運算,以減少資料在記憶體中反覆讀取的次數,提升運算效能。

- NumPy:Python 語言中最基礎的科學計算庫,主要用於處理多維陣列與矩陣運算。

- Transformer:一種基於注意力機制的深度學習模型架構,是目前大型語言模型如 GPT 系列的核心技術。

- TPU:Tensor Processing Unit,張量處理單元,是 Google 專門為機器學習運算設計的應用專用積體電路,能顯著提升張量運算的效率。

- 核心語言:在高效能運算中,用於撰寫直接在運算單元上執行的底層程式碼語言,如 Pallas 即可直接控制硬體資源。

- API:應用程式介面,是一組定義明確的溝通規範,讓不同的軟體元件能夠互相交換資料或調用功能。